多模态学习笔记:从 ALBEF 到 LAMP

🧠 研究方向

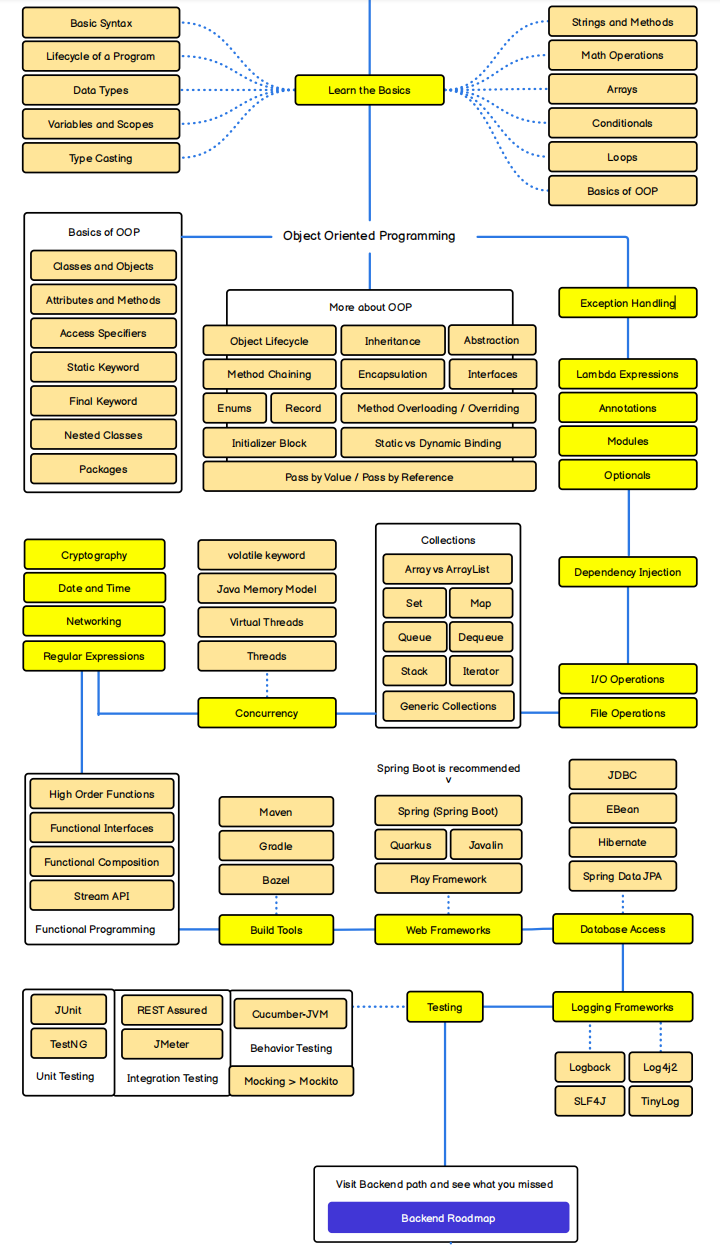

主要关注 Vision-Language Pre-training (VLP) 模型的研究。

核心论文复现

- ALBEF: Align before Fuse. 学习它是如何通过对比学习对齐图像和文本特征的。

- LAMP: 我的重点研究对象,分析其在情感分析任务上的表现。

- PEKD: 知识蒸馏在多模态中的应用。

实验记录

- 环境: PyTorch + NVIDIA 3090/4090

- 难点: 多模态数据的对齐与融合策略

- 指标: Accuracy, F1-Score

保持对 SOTA (State Of The Art) 的敏感度。

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 达芬奇的博客!